正则化,理解、实现与应用

正则化(Regularization)是机器学习中的一种技术,用于防止模型过拟合。过拟合是指模型在训练数据上表现良好,但在未见过的数据上表现不佳。正则化通过向损失函数添加一个惩罚项来实现,这个惩罚项通常是模型参数的平方和或者绝对值之和。

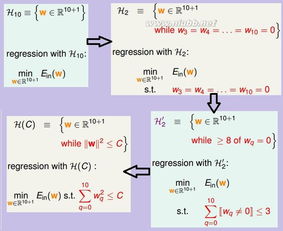

正则化有两种主要类型:

1. L1 正则化(L1 Regularization):也称为 Lasso 正则化,它通过向损失函数添加模型参数的绝对值之和来惩罚模型。L1 正则化倾向于产生稀疏的模型,即许多参数为零。

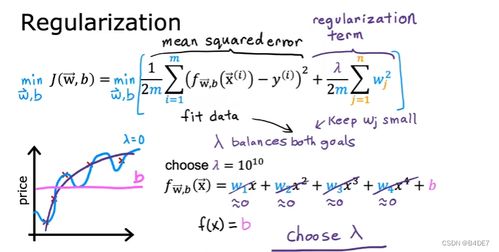

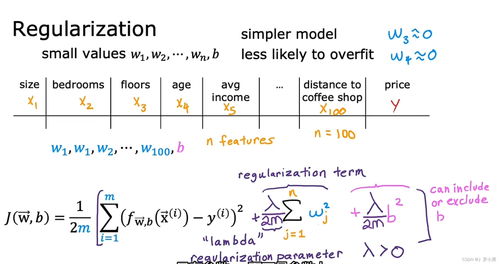

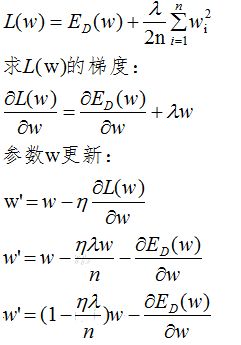

2. L2 正则化(L2 Regularization):也称为 Ridge 正则化,它通过向损失函数添加模型参数的平方和来惩罚模型。L2 正则化倾向于产生平滑的模型,即参数值较小。

正则化参数(也称为正则化系数)控制着正则化项的强度。较大的正则化参数会导致模型更加平滑,从而减少过拟合的风险,但也可能导致模型欠拟合。

在机器学习模型中,正则化通常与优化算法(如梯度下降)结合使用,以找到模型参数的最佳值。正则化可以显著提高模型的泛化能力,使其在未见过的数据上表现更好。

深度学习中的正则化:理解、实现与应用

随着深度学习技术的飞速发展,其在各个领域的应用越来越广泛。然而,深度学习模型在训练过程中容易出现过拟合现象,导致模型在测试数据上的表现不佳。为了解决这个问题,正则化技术应运而生。本文将详细介绍正则化的概念、实现方法以及在深度学习中的应用。

一、正则化的概念

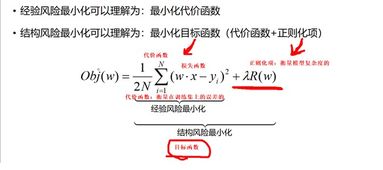

正则化是一种在机器学习模型中引入惩罚项的技术,旨在降低模型的复杂度,提高模型的泛化能力。简单来说,正则化就是通过限制模型参数的规模,防止模型在训练数据上过度拟合,从而在测试数据上获得更好的表现。

二、过拟合与正则化

过拟合是指模型在训练数据上表现得非常好,但在测试数据上表现不佳的现象。这是因为模型在训练过程中过度拟合了训练数据的噪声和细节,导致模型泛化能力下降。为了解决过拟合问题,正则化技术被广泛应用于深度学习模型中。

三、常见的正则化方法

1. L2正则化(权重衰减)

L2正则化通过在损失函数中添加权重平方和的惩罚项来实现。这种惩罚项会使得模型参数的规模变小,从而降低模型的复杂度。L2正则化可以防止模型参数过大,提高模型的泛化能力。

2. L1正则化(Lasso正则化)

L1正则化通过在损失函数中添加权重绝对值和的惩罚项来实现。这种惩罚项会使得模型参数的绝对值变小,从而可能导致某些参数变为0,实现特征选择。L1正则化在特征选择和稀疏表示方面具有优势。

3. Dropout

Dropout是一种在训练过程中随机丢弃部分神经元的方法。这种方法可以防止模型对特定神经元过于依赖,提高模型的泛化能力。Dropout类似于正则化,但它是通过在训练过程中动态地改变模型结构来实现的。

四、正则化在深度学习中的应用

1. 在神经网络中引入正则化

在构建神经网络时,可以在损失函数中添加正则化项,如L2正则化或L1正则化,以降低模型的复杂度,提高模型的泛化能力。

2. 在优化算法中引入正则化

在优化算法中,可以通过调整正则化系数来控制正则化的强度,从而在模型复杂度和泛化能力之间取得平衡。

3. 在特征选择中应用正则化

在特征选择过程中,可以利用L1正则化来实现特征选择,从而降低模型的复杂度,提高模型的泛化能力。

正则化是深度学习中一种重要的技术,可以有效解决过拟合问题,提高模型的泛化能力。本文介绍了正则化的概念、实现方法以及在深度学习中的应用,希望对读者有所帮助。